第2特集 生成AIを使いこなす道筋

生成AIの利用と応用

ハルシネーションの意識と対策

松井 健太郎

1

1国立精神・神経医療研究センター病院 臨床検査部

pp.1334-1337

発行日 2025年9月1日

Published Date 2025/9/1

DOI https://doi.org/10.15104/th.2025100020

- 有料閲覧

- 文献概要

- 1ページ目

- 参考文献

はじめに

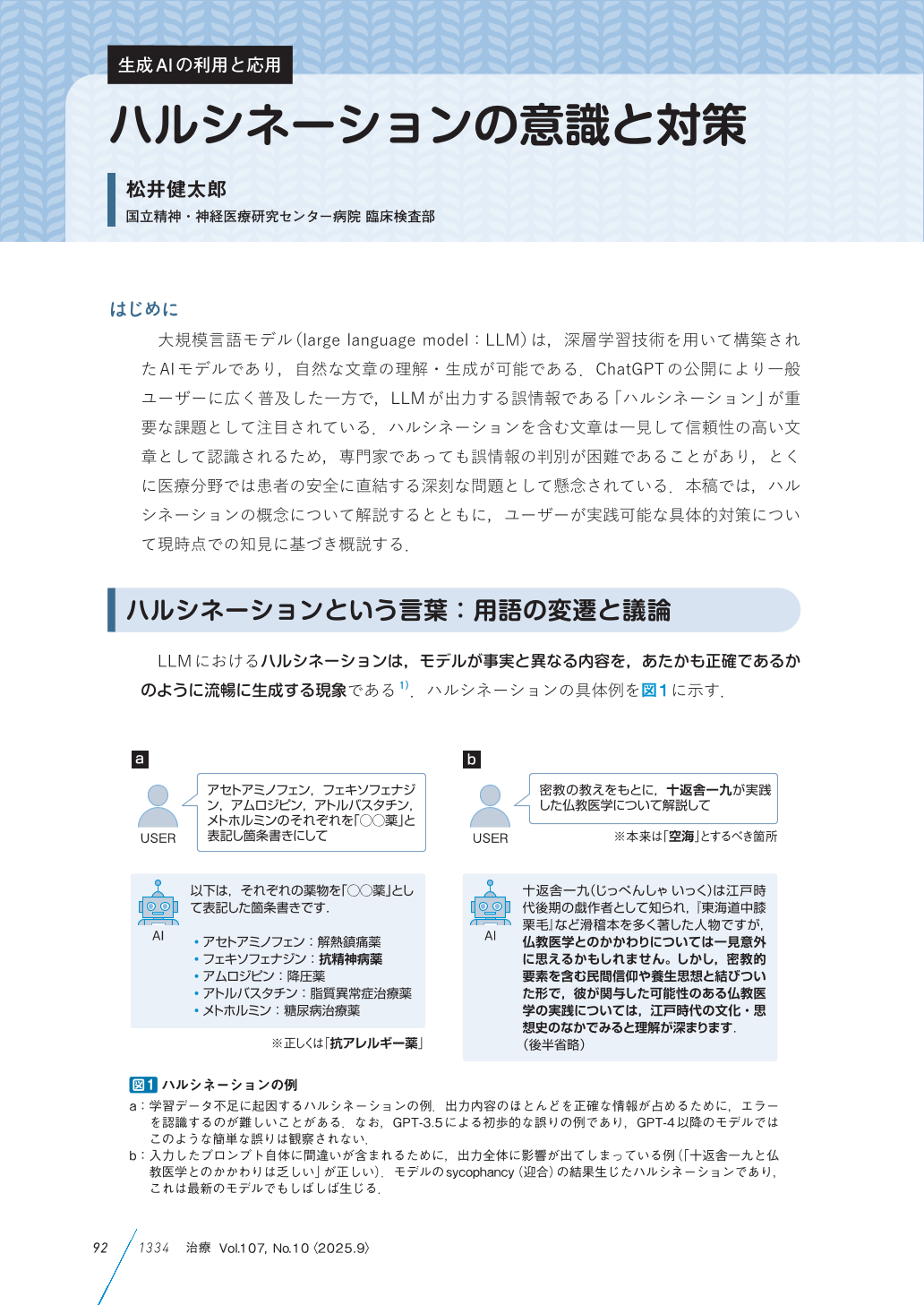

大規模言語モデル(large language model:LLM)は,深層学習技術を用いて構築されたAIモデルであり,自然な文章の理解・生成が可能である.ChatGPTの公開により一般ユーザーに広く普及した一方で,LLMが出力する誤情報である「ハルシネーション」が重要な課題として注目されている.ハルシネーションを含む文章は一見して信頼性の高い文章として認識されるため,専門家であっても誤情報の判別が困難であることがあり,とくに医療分野では患者の安全に直結する深刻な問題として懸念されている.本稿では,ハルシネーションの概念について解説するとともに,ユーザーが実践可能な具体的対策について現時点での知見に基づき概説する.

Copyright© 2025 NANZANDO Co.,Ltd. All Rights Reserved.